序論

人工知能の分野では、ビデオ生成技術が常に研究のホットスポットであり、難問でもあります。技術の継続的な進歩に伴い、ビデオ生成のさまざまな課題を解決するためのモデルが次々と提案されています。最近、中国のチームである階躍星辰が、ギリグループと共同でオープンソースのビデオ生成モデル「Step-Video-T2V」を開発しました。このモデルは、その卓越した性能と革新的な技術で広く注目を集めています。

Step-Video-T2V モデルの概要

(一)モデルの背景

Step-Video-T2V は、階躍星辰チームによって開発されたオープンソースのテキストからビデオへの生成モデルであり、パラメーター数は300億に達します。このモデルは、短時間で最大204フレームの高品質なビデオを生成することができ、544×992ピクセルの解像度をサポートしています。既存のビデオ生成モデルと比較して、Step-Video-T2V は複雑な運動シーンの処理や高品質なビデオ生成において顕著な突破を達成しています。

(二)技術革新

-

深度圧縮の変分オートエンコーダー(Video-VAE):Step-Video-T2V は、16×16の空間圧縮と8倍の時間圧縮を実現する深度圧縮の変分オートエンコーダーを採用しています。この圧縮技術は、ビデオ生成タスクの計算複雑さを大幅に低減しながら、優れたビデオ再構築品質を維持します。

-

バイリンガルテキストエンコーダー:モデルには、中国語と英語のテキストを処理できる2つの事前トレーニングされたバイリンガルテキストエンコーダーが装備されています。これにより、Step-Video-T2V は現在、唯一のオープンソースビデオモデルであり、中国語プロンプトをサポートするため、その应用场景が大幅に拡大します。

-

拡散ベースのトランスフォーマー(DiT)アーキテクチャ:Step-Video-T2V は、3D全方位アテンションメカニズムを備えた拡散トランスフォーマー構造を採用しています。Flow Matchingトレーニング方法を通じて、モデルは強烈な動的効果と高品質な美しさを持つビデオを生成することができます。

-

直接的な好みの最適化(DPO):Step-Video-T2V は、ビデオの品質をさらに向上させるために、ビデオ直接的な好みの最適化(Video-DPO)方法を導入しました。DPOは、人間の好みのデータでモデルを微調整し、アーチファクトを減らし、視覚効果を強化することで、生成されたビデオをより滑らかでリアルにします。

モデルの性能

(一)評価結果

評価結果によると、Step-Video-T2V は以下の点で優れた性能を発揮しています:

-

命令の従順性:モデルはテキストプロンプトを正確に理解し、それに従ってビデオを生成することができます。

-

運動の滑らかさ:複雑なダンスの動きや高速なスポーツのシーンなど、運動シーンにおいても、生成されたビデオは滑らかで自然です。

-

物理の合理性:生成されたビデオは物理法則においても優れており、物体の空間関係と運動法則を正確に処理することができます。

-

美しさの度合い:生成されたビデオは美しさの品質においても優れており、人物のイメージがリアルで詳細が豊富で、全体的な画面が美しくなります。

(二)应用场景

Step-Video-T2V の应用场景は非常に広く、以下に限られません:

ビデオ制作:ビデオクリエーターが高品質なビデオコンテンツを迅速に生成し、時間と労力を節約するのを助けます。

広告制作:広告業界に効率的なビデオ生成ソリューションを提供し、魅力的な広告ビデオを迅速に生成します。

教育分野:教育ビデオの生成に使用され、教師と学生が複雑な概念をより直感的に理解するのを助けます。

エンターテインメント産業:映画、ゲームなどのエンターテインメント産業では、Step-Video-T2V はさまざまなクリエイティブなビデオを生成し、ユーザー体験を向上させることができます。

使用方法

(一)環境の準備

Step-Video-T2V の実行には以下の環境が必要です:

| モデル | 高さ/幅/フレーム | ピークGPUメモリ | 50ステップw flash-attn | 50ステップw/o flash-attn |

|---|---|---|---|---|

| Step-Video-T2V | 544px992px204f | 77.64 GB | 743 s | 1232 s |

| Step-Video-T2V | 544px992px136f | 72.48 GB | 408 s | 605 s |

-- NVIDIA GPUが必要で、CUDAをサポートする必要があります。

-- 80GBのメモリを備えたGPUをお勧めします。

-- テストされたオペレーティングシステム:Linux。

-- テキストエンコーダーは、CUDA機能sm_80 sm_86およびsm_90のみをサポートします。

(二)依存関係のインストール

bash

git clone https://github.com/stepfun-ai/Step-Video-T2V.git conda create -n stepvideo python=3.10 conda activate stepvideo

cd Step-Video-T2V pip install -e . pip install flash-attn --no-build-isolation ## flash-attnはオプションです

(三)推論スクリプトの実行

bash

python api/call_remote_server.py --model_dir where_you_download_dir & ## 4つ以上のGPUがあると仮定します。このコマンドは、テキストエンコーダーとVAEデコーダーのAPI URLを返します。

parallel=4 # または parallel=8 url='127.0.0.1' model_dir=where_you_download_dir

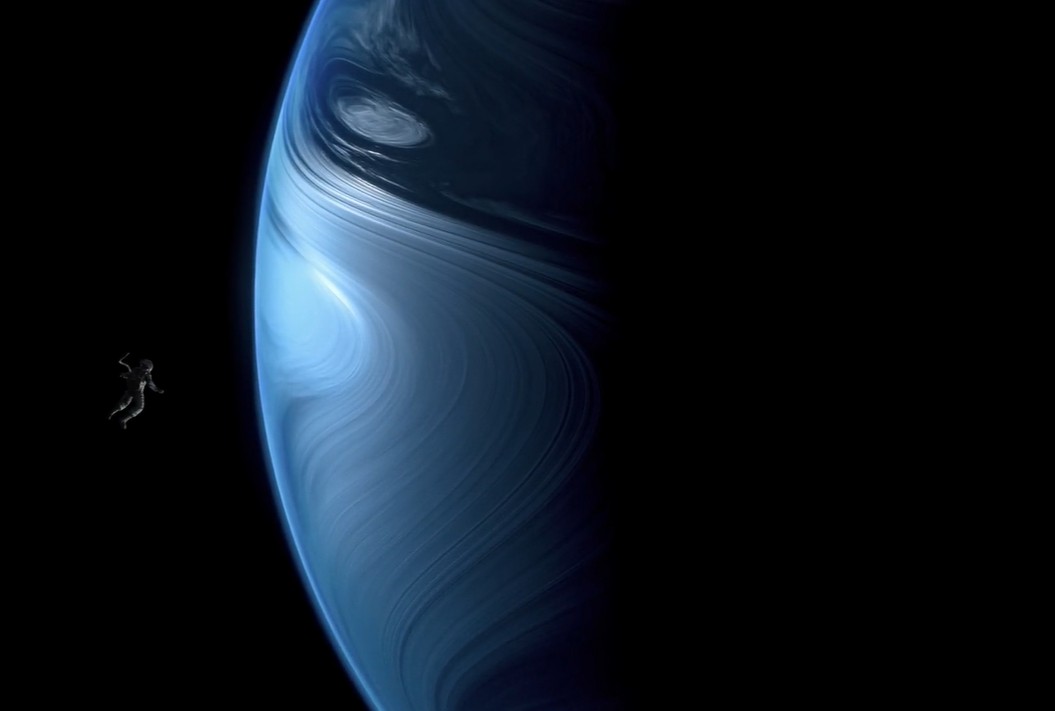

torchrun --nproc_per_node $parallel run_parallel.py --model_dir $model_dir --vae_url $url --caption_url $url --ulysses_degree $parallel --prompt "一名宇航员在月球上发现一块石碑,上面印有“stepfun”字样,闪闪发光" --infer_steps 50 --cfg_scale 9.0 --time_shift 13.0

(四)ベストプラクティスの推論設定

| モデル | infer_steps | cfg_scale | time_shift | num_frames |

|---|---|---|---|---|

| Step-Video-T2V | 30-50 | 9.0 | 13.0 | 204 |

| Step-Video-T2V-Turbo (Inference Step Distillation) | 10-15 | 5.0 | 17.0 | 204 |

リソース

GitHubリポジトリ:https://github.com/stepfun-ai/Step-Video-T2V HuggingFaceリポジトリ:https://huggingface.co/stepfun-ai/stepvideo-t2v 躍問ビデオオンライン生成:https://yuewen.cn/videos

aiスピーキング

ドルフィンAIは言語学習アプリケーションのためのプロフェッショナルな発音評価API(pronunciation assessment api)ソリューションを提供します。音素、単語、文章、チャプター、発音矯正、単語矯正、クイズ、フリーダイアログ、多肢選択問題など幅広く提供しています。当社の発音評価製品(pronunciation assessment)は、英語と中国語、クラウドAPI、オンプレミス、オフラインデバイスの展開をサポートしています。当社の発音評価API(pronunciation assessment api)は、正確性、流暢性、完全性、リズムの次元をカバーする豊富な評価指標を提供し、音素、単語、文の異なるレベルの評価スコアも提供します。また、音素、単語、文の異なるレベルでの評価スコアも提供します。数千万人のユーザーに安定した効率的で安全なサービスを提供しています。ドルフィンAIの発音評価製品(pronunciation assessment)を試してみませんか?