概要

2025 年 2 月 24 日、360 智脑チームと北京大学が共同で開発した中間レベルの推論モデル Tiny-R1-32B-Preview が正式にリリースされました。このモデルは、わずか 5% のパラメーターで Deepseek-R1-671B のフルパフォーマンスに近づくことに成功し、小規模モデルが効率的な推論分野で持つ巨大な可能性を示しました。この成果は、Tiny-R1-32B-Preview の卓越したパフォーマンスを証明するだけでなく、推論コストを大幅に削減する効率の飛躍を実現しました。

コアブレイクスルー:小さなモデル、大きなエネルギー

数学分野

数学分野では、Tiny-R1-32B-Preview は AIME 2024 の評価で 78.1 点の成績を収め、元の R1 モデルの 79.8 点に近い結果を示しました。これは、Deepseek-R1-Distill-Llama-70B の 70.0 点をはるかに上回っています。

プログラミングと科学分野

プログラミングと科学の分野では、このモデルはそれぞれ LiveCodeBench と GPQA-Diamond のテストで 61.6 点と 65.0 点の成績を収め、現在の最高のオープンソース 70B モデルである Deepseek-R1-Distill-Llama-70B を全面的に上回りました。

効率の飛躍

わずか 5% のパラメーターで、元の R1 の 95% 以上のパフォーマンスを達成し、推論コストを大幅に削減しました。

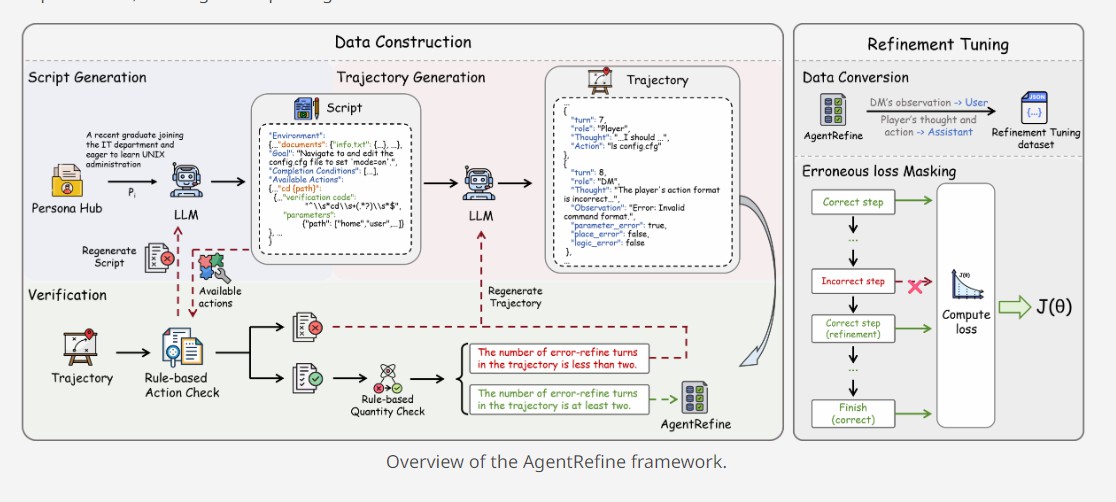

技術革新:分野の専門知識とモデルの融合

研究チームは、「分割統治 - 統合」戦略を採用し、DeepSeek-R1 を基に大量の分野データを生成し、数学、プログラミング、科学の 3 つの垂直分野のモデルを個別にトレーニングしました。Arcee チームが提供する Mergekit ツールをスマートに統合することにより、単一モデルの性能上限を突破し、マルチタスクのバランスの取れた最適化を実現しました。

評価

モデル 数学 (AIME 2024) コーディング (LiveCodeBench) 科学 (GPQA-Diamond) Deepseek-R1-Distill-Qwen-32B 72.6 57.2 62.1 Deepseek-R1-Distill-Llama-70B 70.0 57.5 65.2 Deepseek-R1 79.8 65.9 71.5 Tiny-R1-32B-Preview (Ours) 78.1 61.6 65.0

すべてのスコアは pass@1 で報告されています。AIME 2024 のために 16 つのレスポンスサンプルを引き出しました。GPQA-Diamond のために 4 つのレスポンスサンプルを引き出しました。両者は、平均的な全体的な精度を使用して安定した評価を行いました。

方法

データ

1.数学:open-r1/OpenR1-Math-220k から 58.3k CoT トラックを引き出し、デフォルトのサブセットを使用します。

2.コーディング:19k CoT トラック open-thoughts/OpenThoughts-114k、コーディング サブセット。

3.科学:7.6k のシード サンプル上で 8 つの CoT トラックを生成し、合計 60.8k の CoT トラックを取得しました。シード サンプルには次のものが含まれます。

-

simplescaling/data_ablation_full59K から 2.7k のシード サンプル、科学と健康科学のサブセット

-

open-thoughts/OpenThoughts-114k から 4.9k のシード サンプル、科学のサブセット

コード

依存関係をインストールする:

pip install transformers bitsandbytes -U

モデルをロードしてレスポンスを生成する:

from transformers import AutoModelForCausalLM, AutoTokenizer, BitsAndBytesConfig

quantization_config = BitsAndBytesConfig(load_in_4bit=True)

model_name = "qihoo360/TinyR1-32B-Preview" model = AutoModelForCausalLM.from_pretrained( model_name, torch_dtype="auto", device_map="auto", trust_remote_code=True, quantization_config=quantization_config ) tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

prompt = "Is 123 a prime?" inputs = tokenizer(prompt, return_tensors="pt", padding=True, truncation=True).to(model.device) generated_ids = model.generate(**inputs, max_new_tokens=100) response = tokenizer.batch_decode(generated_ids)[0] print(response)

オープンソースの約束:技術の普惠を推進する

モデル リポジトリ:https://huggingface.co/qihoo360/TinyR1-32B-Preview

研究チームは、完全な技術レポート、トレーニング コード、および一部のデータセットを公開する予定であり、オープンソースの精神を実践し、AI コミュニティが効率的な推論の新しいエコシステムを共同で構築するのを支援します。

aiスピーキング

ドルフィンAIは言語学習アプリケーションのためのプロフェッショナルな発音評価API(pronunciation assessment api)ソリューションを提供します。音素、単語、文章、チャプター、発音矯正、単語矯正、クイズ、フリーダイアログ、多肢選択問題など幅広く提供しています。当社の発音評価製品(pronunciation assessment)は、英語と中国語、クラウドAPI、オンプレミス、オフラインデバイスの展開をサポートしています。当社の発音評価API(pronunciation assessment api)は、正確性、流暢性、完全性、リズムの次元をカバーする豊富な評価指標を提供し、音素、単語、文の異なるレベルの評価スコアも提供します。また、音素、単語、文の異なるレベルでの評価スコアも提供します。数千万人のユーザーに安定した効率的で安全なサービスを提供しています。ドルフィンAIの発音評価製品(pronunciation assessment)を試してみませんか?