BERTに基づく中国語Baseプリトレインモデルの紹介(ドキュメント更新中)

BERTの中国語Baseプリトレインモデルは、wikipediaのデータとmasked language modelタスクを使用してトレーニングされた中国語自然言語理解のプリトレインモデルです。

モデルの説明

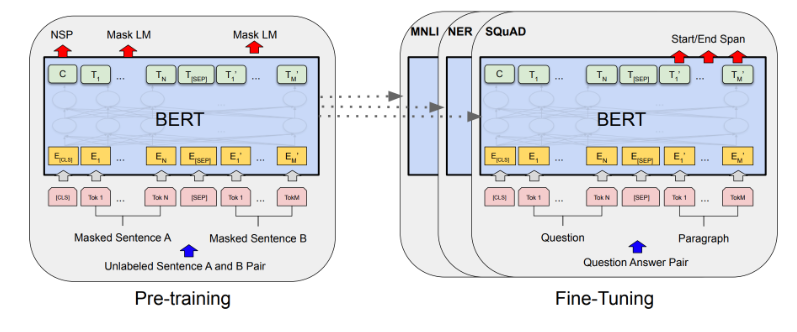

BERTはTransformer Encoderモジュールに基づく双方向エンコーディング表示モデルです。BERTは大規模な無標識語料庫に対してMLMおよびNSPタスクを通じて無監督プリトレインを行なっており、自然言語を良好にモデリングすることができます。詳細については論文「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」を参照してください。

このモデルはBaseサイズ(Layer-12 / Hidden-768 / Head-12)で、パラメーターサイズは約102Mです。

モデルの使用方法と適応範囲

このモデルは主に中国語のダウンストリームタスクのファインチューニングに使用されます。ユーザーは独自のトレーニングデータを使用してファインチューニングできます。具体的な使用方法については、コードの例を参照してください。

使用方法 ModelScope-libをインストールした後、nlp_bert_backbone_base_stdをベースにダウンストリームタスクのファインチューンが行えます。

コードの例

from modelscope.metainfo import Preprocessors

from modelscope.msdatasets import MsDataset

from modelscope.trainers import build_trainer

from modelscope.utils.constant import Tasks

# このメソッドを通じてcfgを変更します。

def cfg_modify_fn(cfg):

# バックボーンモデルを文章の類似度モデルクラスにロードします。

cfg.task = Tasks.sentence_similarity

# 文章の類似度のプリプロセッサを使用します。

cfg['preprocessor'] = {'type': Preprocessors.sen_sim_tokenizer}

# 通常はこのコードの修正を行わないでください。

cfg.train.dataloader.workers_per_gpu = 0

cfg.evaluation.dataloader.workers_per_gpu = 0

# データセットの特徴を補足します。

cfg['dataset'] = {

'train': {

# 実際のlabelフィールドの内容を列挙、バックボーンのトレーニング時に渡す必要があります。

'labels': ['0', '1'],

# 第1フィールドのkey

'first_sequence': 'sentence1',

# 第2フィールドのkey

'second_sequence': 'sentence2',

# labelのkey

'label': 'label',

}

}

# lr_schedulerの設定

cfg.train.lr_scheduler.total_iters = int(len(dataset['train']) / 32) * cfg.train.max_epochs

return cfg

# clueのafqmcを使用してトレーニングします。

dataset = MsDataset.load('clue', subset_name='afqmc')

kwargs = dict(

model='damo/nlp_bert_backbone_base_std',

train_dataset=dataset['train'],

eval_dataset=dataset['validation'],

work_dir='/tmp',

cfg_modify_fn=cfg_modify_fn)

# nlp-base-trainerを使用します。

trainer = build_trainer(name='nlp-base-trainer', default_args=kwargs)

trainer.train()モデルの限界と可能性のあるバイアス

中国語データに基づいてトレーニングされ、モデルのトレーニングデータが限られているため、効果に一定のバイアスが存在する可能性があります。

トレーニングデータの紹介 データはhttps://huggingface.co/datasets/wikipediaから来ています。

モデルのトレーニングプロセス 中国語wikiなどの無監督データで、MLMおよびNSPの2つの補助タスクを通じてトレーニングされます。

データの評価と結果 なし

関連する論文および引用情報

私たちのモデルが役立つ場合は、以下の論文を引用してください。

@article{devlin2018bert, title={Bert: Pre-training of deep bidirectional transformers for language understanding}, author={Devlin, Jacob and Chang, Ming-Wei and Lee, Kenton and Toutanova, Kristina}, journal={arXiv preprint arXiv:1810.04805}, year={2018} } ドルフィンAIは言語学習アプリケーションのためのプロフェッショナルな発音評価API(pronunciation assessment api)ソリューションを提供します。音素、単語、文章、チャプター、発音矯正、単語矯正、クイズ、フリーダイアログ、多肢選択問題など幅広く提供しています。当社の発音評価製品(pronunciation assessment)は、英語と中国語、クラウドAPI、オンプレミス、オフラインデバイスの展開をサポートしています。当社の発音評価API(pronunciation assessment api)は、正確性、流暢性、完全性、リズムの次元をカバーする豊富な評価指標を提供し、音素、単語、文の異なるレベルの評価スコアも提供します。また、音素、単語、文の異なるレベルでの評価スコアも提供します。数千万人のユーザーに安定した効率的で安全なサービスを提供しています。ドルフィンAIの発音評価製品(pronunciation assessment)を試してみませんか?