最近、LiveKit と OpenAI はパートナーシップを結び、この協力は OpenAI の高度な音声機能をデベロッパーが利用できる API に変換することを目的としています。これにより、デベロッパーは ChatGPT と同じエンドツーエンドの技術を利用して自分のアプリケーションを構築することができ、音声インタラクションの分野に大きな変革をもたらします。

高度な音声機能の実現原理

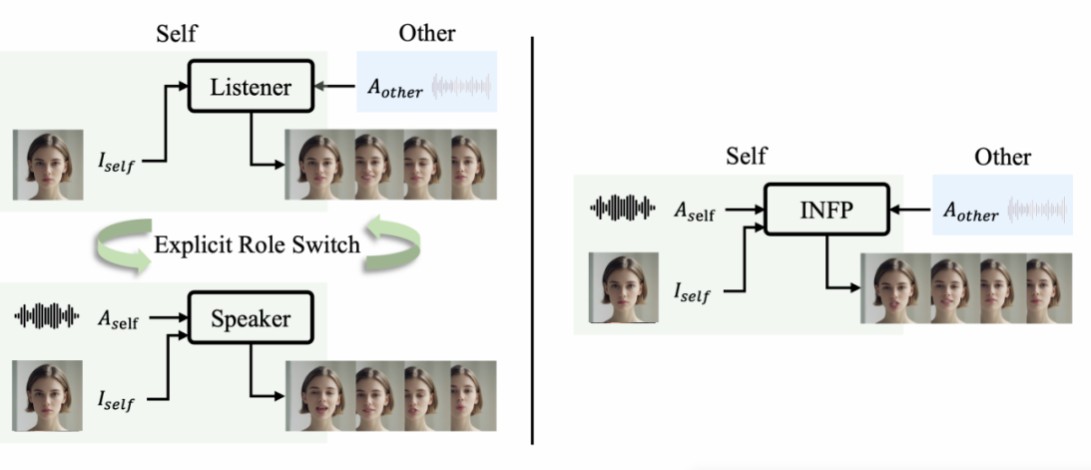

高度な音声機能のコアは、ChatGPT がユーザーが話している「内容」だけでなく、「話し方」も理解できることです。そして、約 300 ミリ秒(人間の音声の遅延しきい値)以内に反応し、一連の人間の感情を表現することができます。その動作プロセスは以下のとおりです。

- ユーザーの音声はまず、ChatGPT アプリケーション内の LiveKit クライアント SDK でキャプチャされます。

- 次に、ユーザーの音声は LiveKit Cloud を介して OpenAI の音声エージェントに伝えられます。

- 音声エージェントは音声プロンプトを GPT-4o に転送します。

- GPT-4o は推論を実行し、音声パケットをエージェントにストリーミングで返します。

- 最後に、エージェントは LiveKit クラウドを通じて生成された音声をユーザーのデバイスに転送します。

このプロセスには、従来の HTTP リクエスト - レスポンスモデルとは異なるアーキテクチャが必要です。OpenAI は、音声エージェントと GPT-4o の間の通信を実現するために WebSocket を使用し、リアルタイム API でデベロッパーにこのインターフェースを公開しています。しかし、最終ユーザー アプリケーションでは、データパケットの損失を処理する上で WebSocket には限界があります。特に WiFi またはセルラーなどの損失の多いネットワーク環境ではそうです。したがって、OpenAI は WebRTC プロトコルを採用しました。このプロトコルは、サーバーとクライアントの間で超低遅延の音声を伝送するために特別に設計されており、ネットワーク条件に応じてビットレートを調整できる組み込みコーデックを持ち、ほとんどのプラットフォームで使用できます。LiveKit は、WebRTC を簡素化するオープンソースのインフラストラクチャであり、その LiveKit Cloud は、大規模で信頼性高く音声を伝送し、可能な限り低い遅延を実現するように最適化されたグローバルサーバーネットワークです。

LiveKit と OpenAI リアルタイム API の組み合わせ

LiveKit は、OpenAI の新しいリアルタイム API を組み込んだ新しいマルチモーダルエージェント API を提供しています。これにより、デベロッパーは GPT-4o を使ってリアルタイムで聴き、ユーザーと会話するアプリケーションを構築できるようになりました。バックエンドでは、新しいマルチモーダル API は、OpenAI のリアルタイム API を完全にラップし、原始的な线路プロトコルを抽象化し、GPT-4o にクリーンな「ストレート」インターフェースを提供することを目指しています。MultimodalAgent クラスは、ストリーミング テキストと音声モードを動的に処理し、入力と出力を任意のモードでサポートし、ユーザーのデバイスで再生されるテキストトランスクリプトと音声を時間軸に合わせることができます。これは、字幕などの機能にとって非常に便利です。さらに、すべてのリアルタイム API パラメーターが透過的にサポートされており、MultimodalAgent は Agents フレームワークの既存の機能と統合されています。これは、バッファリング再生、関数呼び出し、ロードバランシング、電話統合などが含まれます。

フロントエンドでは、LiveKit は新しいフック、モバイルコンポーネント、ビジュアライゼーションツールを提供し、クライアントアプリケーションをエージェントに接続するプロセスを簡素化しています。たとえば、NextJS で、デベロッパーは LiveKit が提供するコンポーネントを使って簡単に音声アシスタント機能を持つインターフェースを構築することができます。

LiveKit の正確な音声ターン検出モデル

LiveKit はまた、ユーザーが話すのを終えたかどうかを正確に判断できるオープンソースの正確な音声ターン検出モデルを開発しました。このモデルは、Transformer モデルと従来の音声活動検出(VAD)を組み合わせることで、従来の VAD モデルよりもはるかに正確な「ターンの終わり」の検出を提供します。このモデルは、音声信号の有無だけでなく、音声の意味を分析し、話が終わっているかどうかを理解することができます。これにより、人間とコンピューターの対話の流れと自然さが大幅に向上し、AI の「間違って遮断」を減らし、音声アシスタントやカスタマーサービス ロボットなどの AI アプリケーションがユーザーの発言が終わったかどうかをより正確に判断し、それに対して応答できるようになりました。

アプリケーションシナリオと将来の展望

高度な音声機能が API の形で提供されるようになったことで、デベロッパーは信じられないほど優れた AI ネイティブアプリケーションを構築することができます。GPT-4o のマルチモーダルなトレーニングは推論遅延を大幅に減らし、言語をまたがって人間の感情を理解し、表現する能力を与えました。この新しい技術は、カスタマーサポートや遠隔医療、言語学習、ビデオゲーム NPC、治療や瞑想などの分野ですぐに応用されるでしょう。たとえば、カスタマーサポートや遠隔医療の分野では、音声が主要なコミュニケーション手段であり、柔軟で共感の強い自動化サービスプロバイダーは、既存の電話ツリーと IVR システムのユーザーエクスペリエンスを大幅にアップグレードします。言語学習の分野では、AI はネイティブスピーカーをよりよく模倣し、学習者によりリアルな言語環境を提供することができます。ビデオゲームでは、豊かな物語が生き生きとした人間のようなキャラクターを通じてリアルタイムで表現され、ゲームの没入感が大幅に向上します。治療や瞑想の分野では、AI とのインタラクションは、心理健康を鍛えるのに役立ち、社会に広範なポジティブな影響をもたらすでしょう。

LiveKit と OpenAI の協力、そして LiveKit 自身の技術革新は、音声インタラクション技術が新しい段階に入ったことを示しています。技術が継続的に発展し続けることで、将来の人間とコンピューターの対話はより自然で、流暢で、賢くなるでしょう。ユーザーにより優れた、人間らしいエクスペリエンスを提供するでしょう。

aiスピーキング

ドルフィンAIは言語学習アプリケーションのためのプロフェッショナルな発音評価API(pronunciation assessment api)ソリューションを提供します。音素、単語、文章、チャプター、発音矯正、単語矯正、クイズ、フリーダイアログ、多肢選択問題など幅広く提供しています。当社の発音評価製品(pronunciation assessment)は、英語と中国語、クラウドAPI、オンプレミス、オフラインデバイスの展開をサポートしています。当社の発音評価API(pronunciation assessment api)は、正確性、流暢性、完全性、リズムの次元をカバーする豊富な評価指標を提供し、音素、単語、文の異なるレベルの評価スコアも提供します。また、音素、単語、文の異なるレベルでの評価スコアも提供します。数千万人のユーザーに安定した効率的で安全なサービスを提供しています。ドルフィンAIの発音評価製品(pronunciation assessment)を試してみませんか?